Your all-in-one platform to explore the web

Anyone, anywhere, can create knowledge from public data.

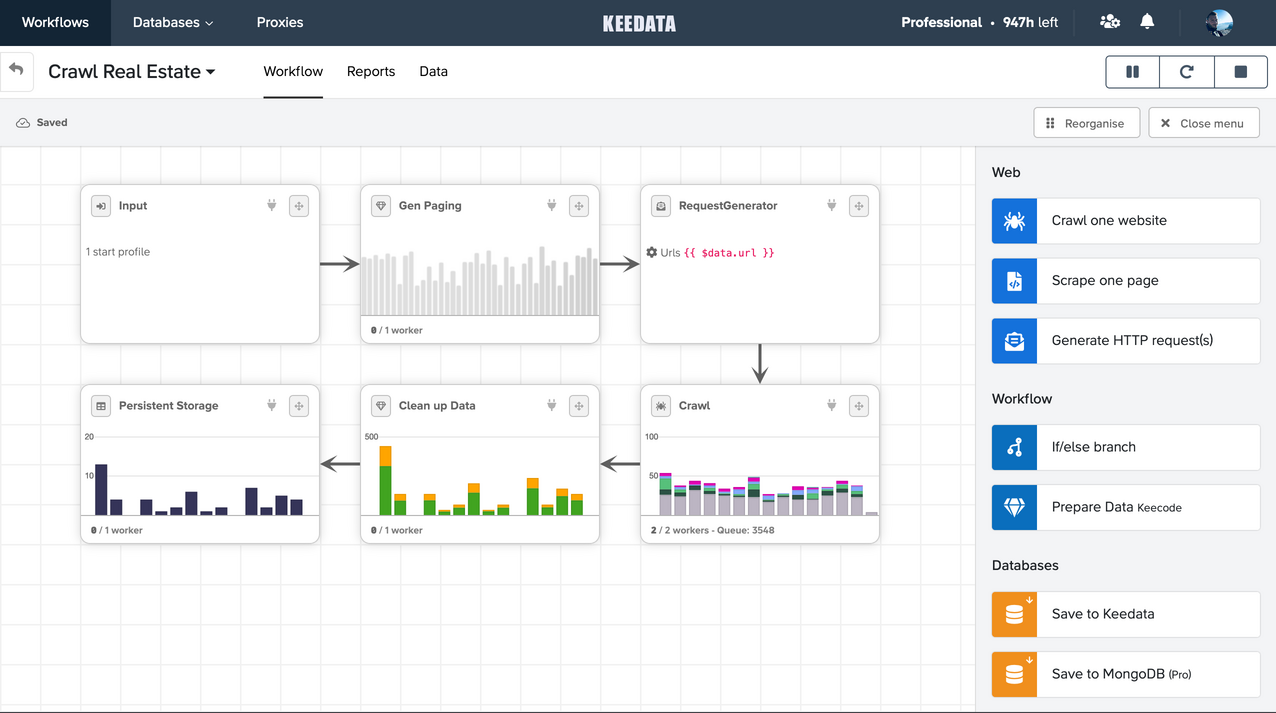

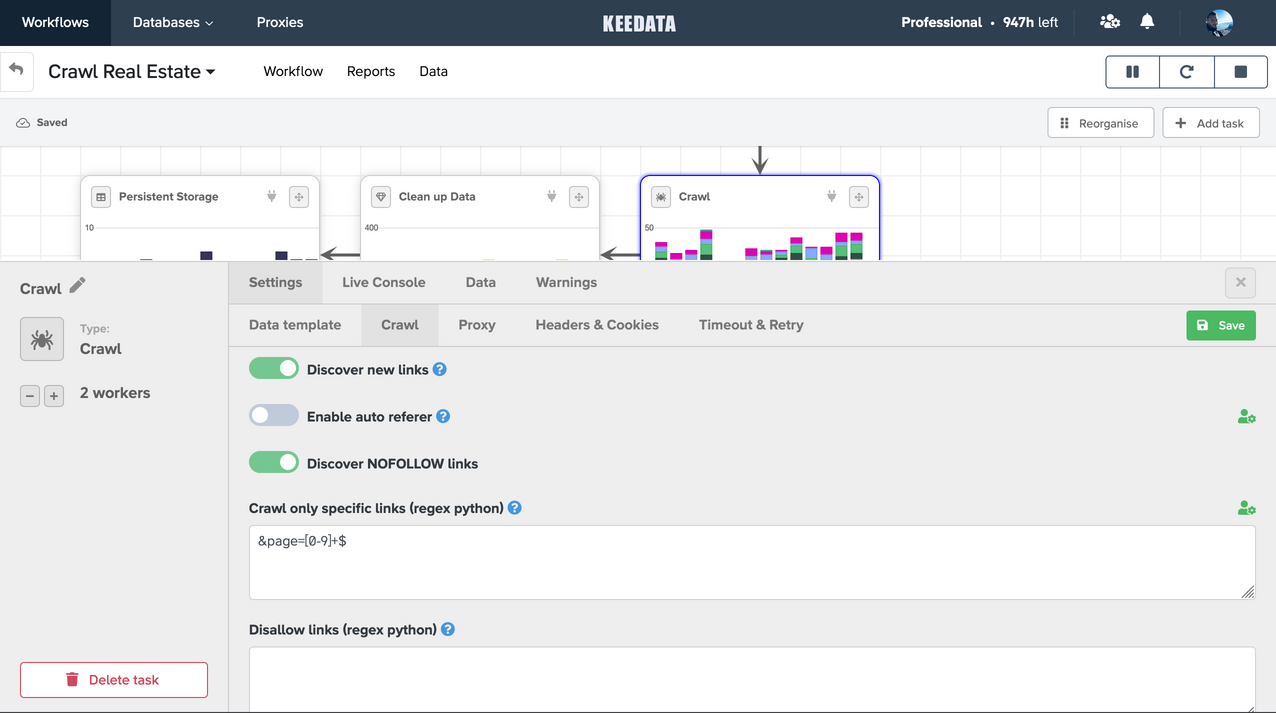

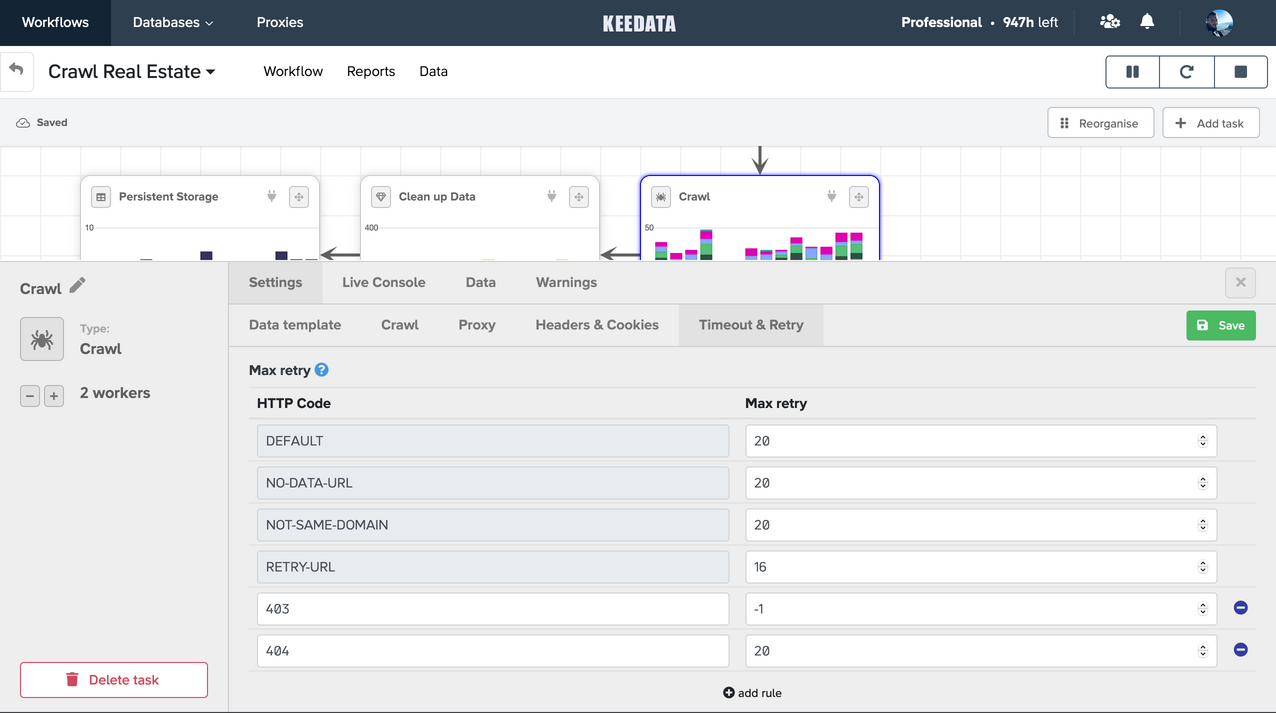

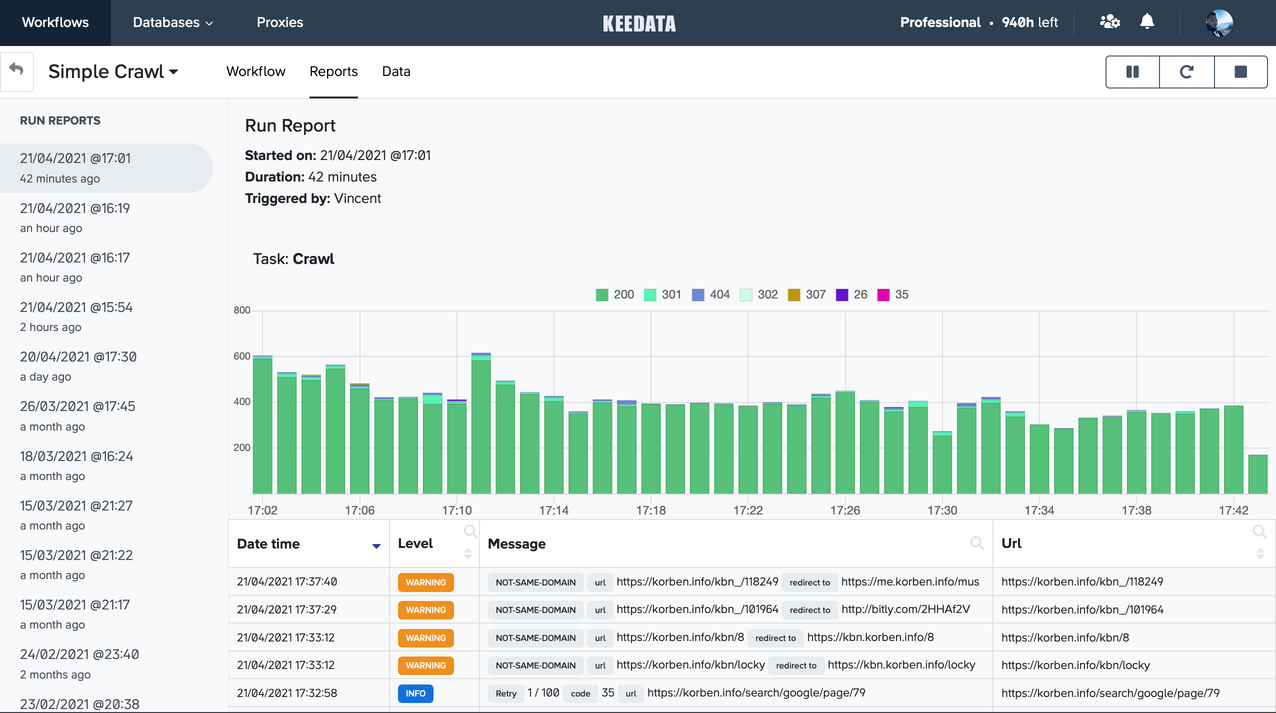

From one-shot scraping projects to industrialized data-mining factories, get quickly on track with a complete toolbox.

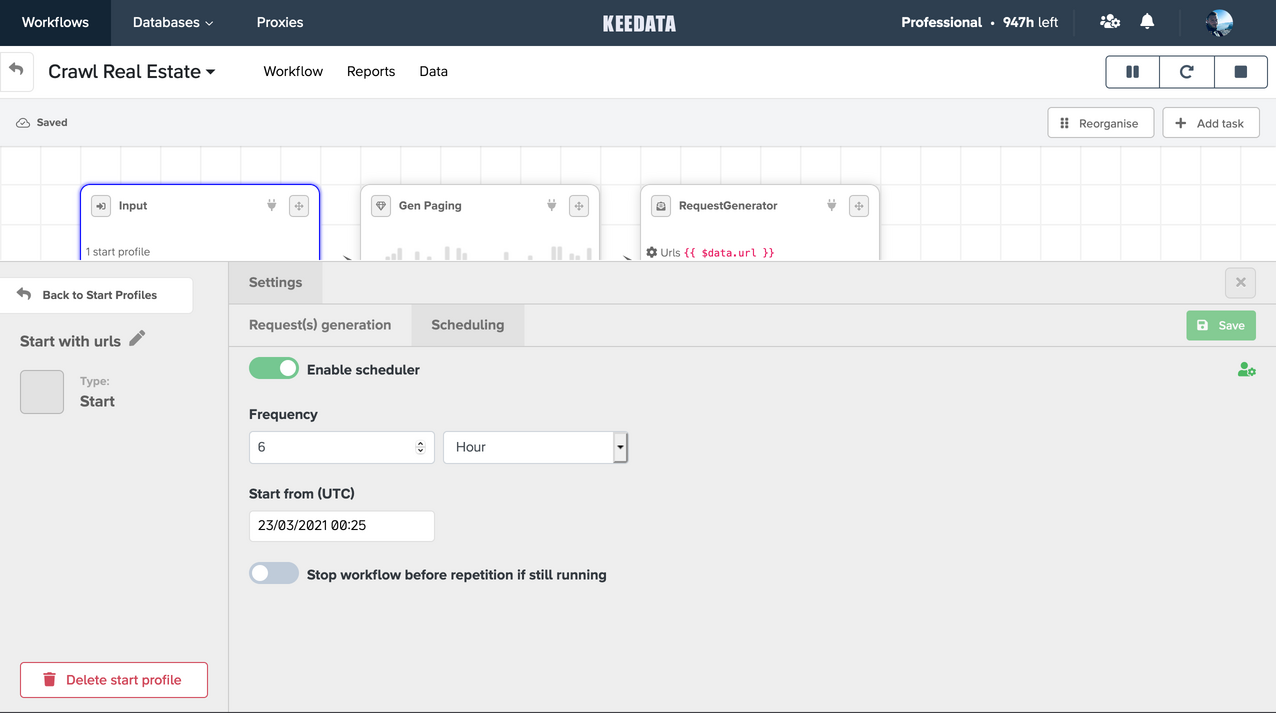

Stay in control with your

Data Templates

While point-and-click systems might be more accessible to non-technical persons, as Data Engineers we feel like coding our Data Templates is the way to go.

Meet the Keecode, an easy-to-learn langage inspired by Python, designed for flawless Data Extraction and Transformation.

Online editor with live debugging

Easy casting and manipulations

Executed in Cloud

Built by scrapers, for scrapers.

Data Hosting

Start scraping now, and instantly feed your provided data storage.

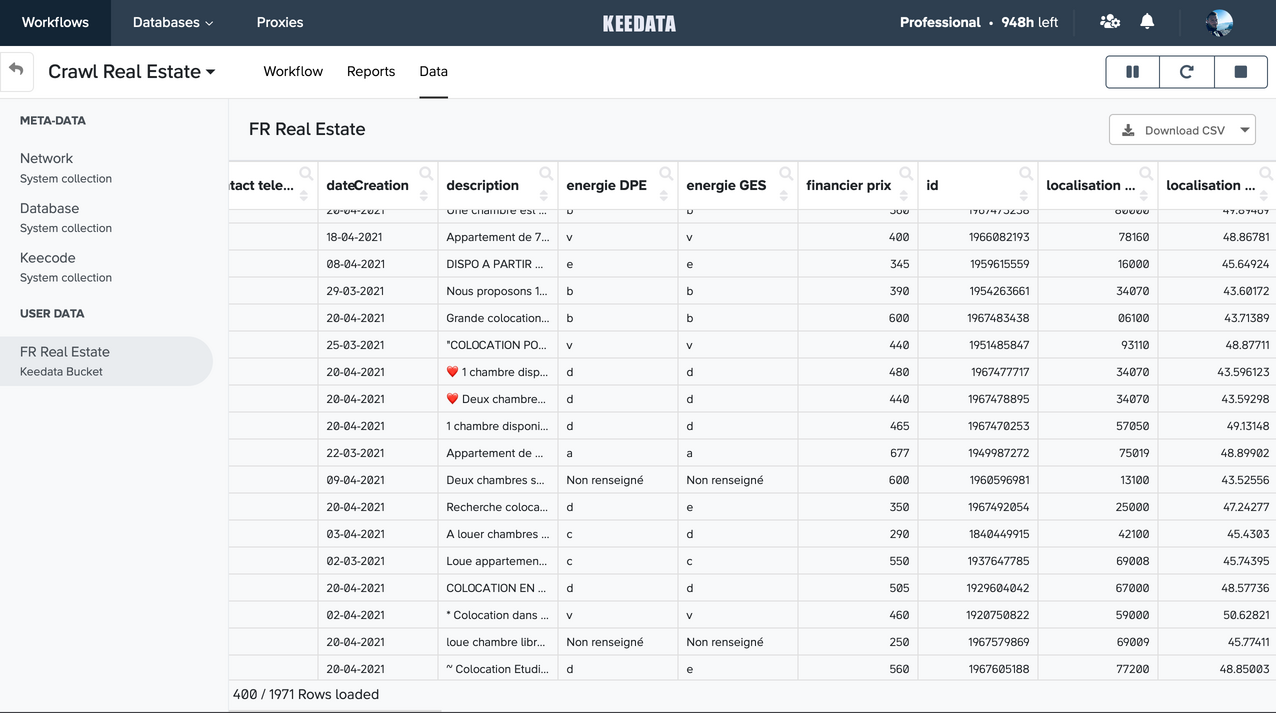

Data Visualization

Conveniently explore your results directly from your browser.

Data Export

Export your results as CSV files, sorted and filtered as you needed.

Fair Pricing

Pay for dedicated resources, and use them as much you want.

Managed Infrastructure

We keep everything up-to-date and monitores the entire stack.

1 click Scalability

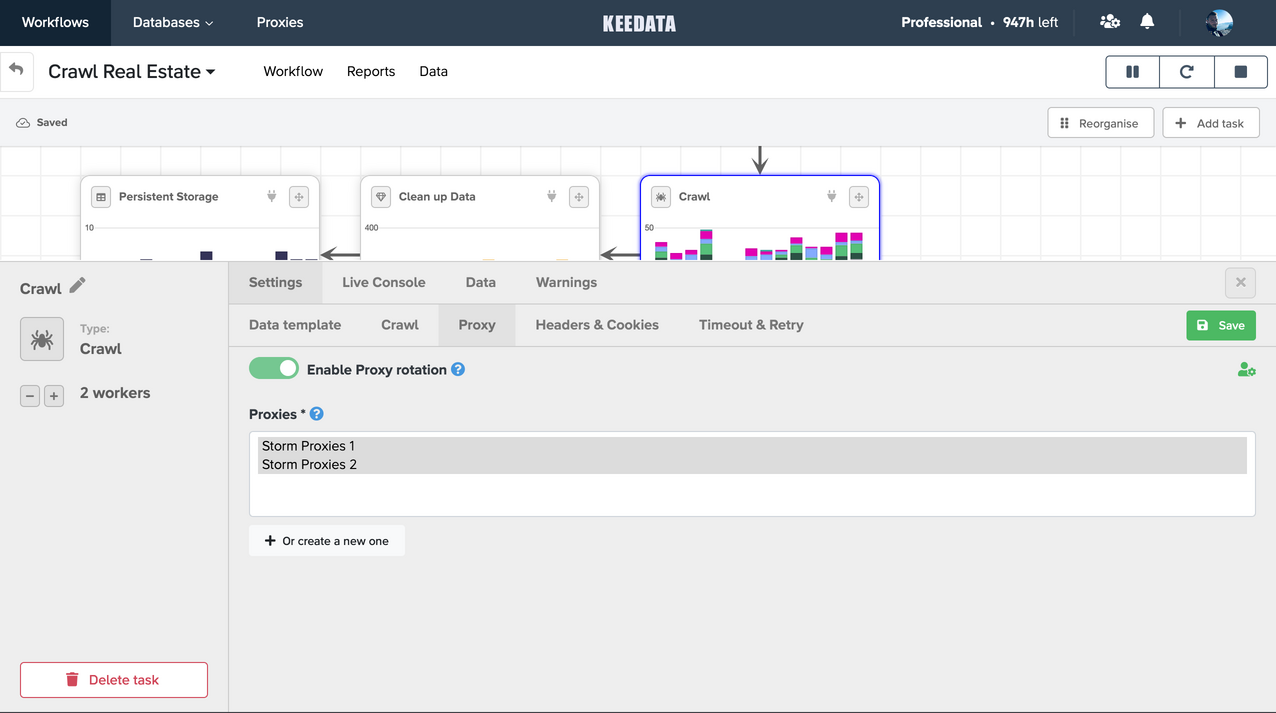

Get all your forces on one task, or evenly spread your workers.

Seamless Integrations

Keep 100% ownership over your data, whatever integration you choose.

- Unlimited Bandwith

- Create • Read • Update

- Secured Transfers

Temporary Storage

- Unlimited rows

- Create • Update

- Retention up to 6 months

Aggregate Storage

- Shared between workflows

- Create • Update

- Retention 6 months

CSV Download

- Unlimited Export

- Up to 1M rows / file

Push to your API

- Unlimited Bandwith

- Secured Transfers

Specific Connector

A specific destination

in mind ?

Feel free to ask.

Feel free to ask.

Start crawling for Free

No credit card required

• Go to Pricing

Back to top